Slike generisane veštačkom inteligencijom mogu prevariti ljude: evo kako da ih prepoznate

- Članak je star više od dve godine.

- Objavljeno 4. aprila 2023. u 15.20

- Ažurirano 26. aprila 2024. u 12.29

- Za čitanje potrebno 10 minuta

- Od: Juliette MANSOUR, AFP Francuska

- Prevod i prilagođavanje Marion DAUTRY

Nedavno razvijeni AI alati kao što su Middžurni (Midjourney), DALL-E, Krejon (Craiyon) ili Stejbl Difjužn (Stable Diffusion) mogu da generišu beskonačan broj slika korišćenjem ogromnih baza podataka.

Mnogi ljudi koriste takve alate u humorističke ili umetničke svrhe, ali drugi se oslanjaju na njih da bi napravili lažne slike koje navodno prikazuju političke vesti.

Na primer, na Tviteru je kružilo mnoštvo slika generisanih veštačkom inteligencijom (arhivirani članak ovde) nakon sastanka Putina i Si Đipinga 20. marta 2023. Drugi su francuskog predsednika Emanuela Makrona prikazali kao radnika gradske čistoće dok se smeće gomilalo na pariskim ulicama usled masovnih štrajkova zbog kontroverznih penzionih reformi.

Iako većina kreatora jasno kaže da su ove naveliko deljene slike izmišljene, druge fotografije kruže bez konteksta ili su predstavljene kao autentične.

Pristalice teorije zavere Qanon – prema kojoj bivši američki predsednik Donald Tramp vodi tajni globalni rat protiv nedefinisanih zlih sila – podelile su fotografije hapšenja aktuelnog američkog predsednika Džoa Bajdena i istaknutih političara iz Demokratske stranke Nensi Pelosi i Hilari Klinton koje je zapravo stvorila veštačka inteligencija. Iz opisa u ovom postu, koji glasi "Evo istine... Tramp je pobijedio", nije jasno da li korisnica Fejsbuka zna da su slike lažne. Objavu su više od 80 puta podelili korisnici u različitim zemljama bez pominjanja porekla slika. Na taj način se izgubi kontekst i izvor sadržaja koji kruži na društvenim mrežama.

Alati za detekciju veštačke inteligencije

Programeri su napravili alate kao što je Haging Fejs (Hugging Face) kako bi pokušali da otkriju ove montaže. Testovi koje je uradio AFP, međutim, pokazuju da rezultati nisu uvek tačni i ponekad mogu da dovedu u zabludu.

Ispod ovog pasusa je jedan niz objavljen na Tviteru na engleskom (arhiviran ovde) u kojem se vidi slika koja prikazuje kako je Vladimir Putin navodno kleknuo pred Si Đinpingom na sastanku u martu 2023. godine. Korisnica tvitera je novinarka koja izveštava iz Kine kao i o novim tehnologijama. Ona objašnjava zašto je slika sumnjiva i najverovatnije napravljena korišćenjem veštačke inteligencije. Do zaključka je došla, između ostalog, uz pomoć programa Haging Fejs.

Hi, I'm a tech reporter that covers China, cybersecurity, & new media. Hundreds of people are sharing this photo of Xi Jinping & Vladimir Putin as they meet at the Kremlin. The two did meet, but it's highly likely this photo was generated by an AI program. Here's why: pic.twitter.com/6xqsDLxiMa

— Amanda Florian 小爱 (@Amanda_Florian) March 21, 2023

"Kada veštačka inteligencija generiše slike (od nule), ne postoji nijedna originalna slika čiji su delovi uzeti", objasnio je 21. marta 2023. godine za AFP Dejvid Fišindžer (David Fischinger), stručnjak za veštačku inteligenciju i inženjer na Austrijskom institutu za tehnologiju. "Hiljade/milioni fotografija je korišćeno za učenje milijardi parametara."

Vinsent Terasi (Vincent Terrasi), suosnivač kompanije Draft & Goal, startapa koji je pokrenuo AI detektor za univerzitetske tekstove, dodao je da "AI meša te slike iz svoje baze podataka, dekonstruiše ih i zatim rekonstruiše fotografiju piksel po piksel, što znači da u konačnom ishodu više ne primećujemo razliku u odnosu na originalne slike."

Zbog toga su softveri za otkrivanje manipulacije loši, ako uopšte funkcionišu, u identifikaciji slika generisanih veštačkom inteligencijom. Metapodaci fotografije, koji ponekad mogu otkriti izvor slike generisane veštačkom inteligencijom, takođe nisu od velike pomoći.

"Nažalost, ne možete se osloniti na metapodatke jer su na društvenim mrežama potpuno uklonjeni," rekla je za AFP stručnjakinja za veštačku inteligenciju Analisa Verdoliva (Annalisa Verdoliva), profesorka na Univerzitetu Frederik II u Napulju.

Nađite izvor slike

Stručnjaci kažu da je pronalazak kada je slika prvi put objavljena na internetu jedan od važnih tragova. U nekim slučajevima, tvorac slike je možda rekao da je generisana veštačkom inteligencijom i naveo korišćeni alat.

Obrnuta pretraga slika može pomoći ako je indeksirana u pretraživačima da biste pronašli ranije postove sa istom fotografijom. Proces je objašnjen u ovom članku na sprskom i na snimku ispod ovog pasusa na engleskom:

Ova metoda omogućila je pronalaženje izvora slika koje navodno pokazuju nasilnu svađu između bivšeg američkog predsednika Donalda Trampa i policajaca koji ga hapse.

Obrnuta pretraga na Guglu je dovela do tvita Eliota Higinsa (Eliot Higgins), osnivača istraživačke grupe Bellingcat, koji je napravio celu seriju slika na temu hapšenja Trampa i njegovog boravka u zatvoru. Te slike je objavio 20. marta 2023. uz objašnjenje da su pravljene korišćenjem veštačke inteligencije.

Higins je u nizu objasnio da je sve slike napravio korišćenjem poslednje verzije programa Midjourney.

Making pictures of Trump getting arrested while waiting for Trump's arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins) March 20, 2023

Ukoliko ne možete da nađete originalnu fotografiju, obrnuta pretraga može dovesti do slike boljeg kvaliteta ili da pokaže da li je izmenjena ili isečena pa ponovo podeljena. Slika boljeg kvaliteta bi bila bolja za analizu.

Obrnuta pretraga slika će takođe pronaći slične snimke, koji mogu biti dragoceni za upoređivanje potencijalnih fotografija generisanih veštačkom inteligencijom sa onima iz pouzdanih izvora.

Za jednu viralnu sliku koja navodno prikazuje Putina kako kleči pred Si Đinpingom, korisnici Tvitera, poput italijanskog novinara Davida Puentea, ukazali su na to da se dekor u prostoriji razlikuje od onog na slikama koje su objavili mediji sa lica mesta.

5/ Compare the meeting room. pic.twitter.com/YuFtXJB2Jp

— David Puente (@DavidPuente) March 21, 2023

Opisi fotografija i komentari korisnika takođe mogu biti korisni u prepoznavanju određenog stila sadržaja generisanog veštačkom inteligencijom. DALL-E je, na primer, poznat po ultrarealističnom dizajnu, a Midjourney po scenama koje prikazuju poznate ličnosti.

Neki alati ostavljaju trag slika generisanih veštačkom inteligencijom na različitim kanalima koje korisnici koriste za međusobne razgovore. Može biti korisno ući na platformu alata koji je korišćen za generisanje slike u pokušaju da se nađe izvor i tvorac slike. Na nekim generatorima, na primer Midjourney, detaljnija pretraga razmene između korisnika i automatskog programa može omogućiti pronalaženje kreiranih fotografija.

Vizuelni tragovi

Čak i bez izvora, detaljnim posmatranjem moguće je analizirati samu sliku.

Tražite vodeni žig

Dokazi o autentičnosti slike mogu biti vidljivi na samoj slici, kao što je vodeni žig koji neki AI alati ostavljaju na slikama.

Program DALL-E na primer automatski generiše višebojnu traku u donjem desnom uglu svih svojih slika. Craiyon stavlja malu crvenu olovku na isto mesto, kao što možete da vidite na slikama ispod:

Ali nemaju sve slike generisane veštačkom inteligencijom vodene žigove - i oni se mogu ukloniti, izrezati ili sakriti.

Saveti iz umetničkog sveta

Tina Nikukha (Tina Nikoukhah), studentkinja doktorskih studija koja izučava obradu slika na Univerzitetu ENS Paris-Saklej, rekla je za AFP: "Ako ste u nedoumici, pogledajte zrnastost slike, koja će se veoma razlikovati na fotografiji generisanoj veštačkom inteligencijom od one na pravoj fotografiji".

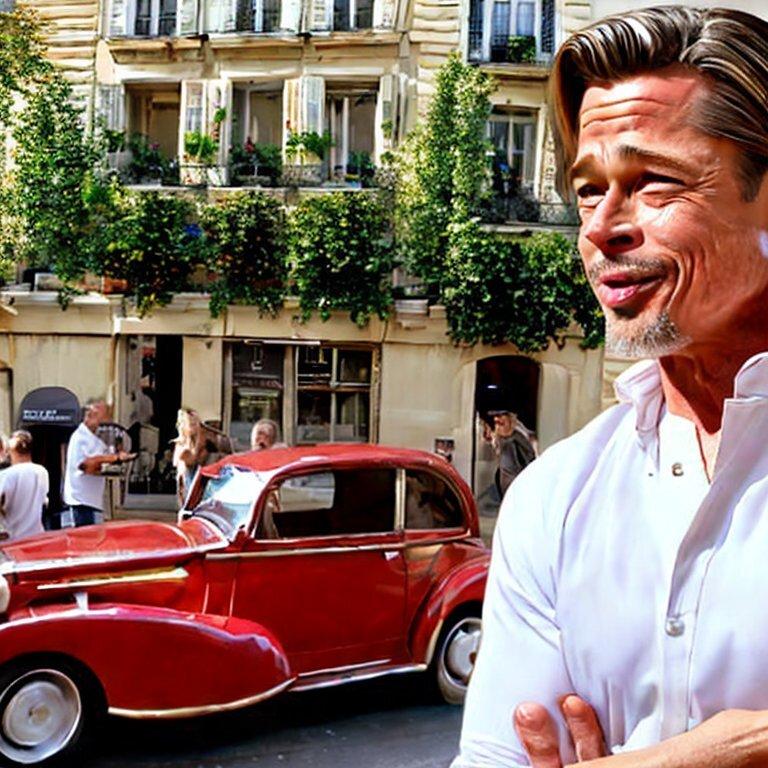

Na besplatnim verzijama AI alata koje je testirao AFP, generisane slike su imale stil koji je prilično sličan delima slikarskog hiperrealističkog pokreta, sa jakim kontrastima, kao što je primer dole levo "Bred Pit u Parizu" koji je kreiran uz pomoć alata Stable Diffusion.

Još jedna kreacija (dole desno), koju je proizveo program DALL-E sa sličnim ključnim rečima, ipak je stvarnija i teže je, na prvi pogled, potvrditi da je to slika koju je stvorila AI.

Vizuelne nedoslednosti

Uprkos munjevitom napretku u tehnologiji veštačke inteligencije, u generisanom sadržaju i dalje se pojavljuju greške. Ovi nedostaci su najbolji način da se prepozna fabrikovana slika, rekli su stručnjaci za AFP.

"Neke karakteristike, često iste, predstavljaju problem za veštačku inteligenciju. Ove nedoslednosti moraju da se potraže, kao u igri uočavanja razlike", rekao je Terasi iz Draft & Goal-a.

Analisa Verdoliva sa Univerziteta Frederik II u Napulju je, međutim, upozorila: metode za generisanje sadržaja "se vremenom poboljšavaju i pokazuju sve manje i manje artefakata sinteze, tako da se dugoročno ne bih oslanjala na vizuelne tragove".

Na primer, u martu 2023. još uvek je teško generisati realne ruke. AFP-ova fotografija Pita koju je napravila veštačka inteligencija prikazuje glumca sa nesrazmerno velikim prstom.

Lažne slike hapšenja Džoa Bajdena i Hilari Klinton koje je stvorila veštačka inteligencija prikazuju, na primer, policajce sa nesrazmernim rukama. Što su ljudi dalje u pozadini, to su manje realni.

Na fotografiji sa Nensi Pelosi, veličina ruku je takođe problematična, a neke deluju čak i spojene. U pozadini, slova na krovu policijskog automobila i na ulazu u zgradu izgledaju nasumična.

"Za sada, alati veštačke inteligencije veoma teško prikazuju i refleksije", rekao je Terasi. "Dobar način da prepoznate veštačku inteligenciju je da potražite senke, ogledala, vodu, ali i da zumirate oči i analizirate zenice jer obično u njima postoji odraz kada fotografišete. Takođe često možemo primetiti da oči nisu iste veličine, ponekad su različite boje".

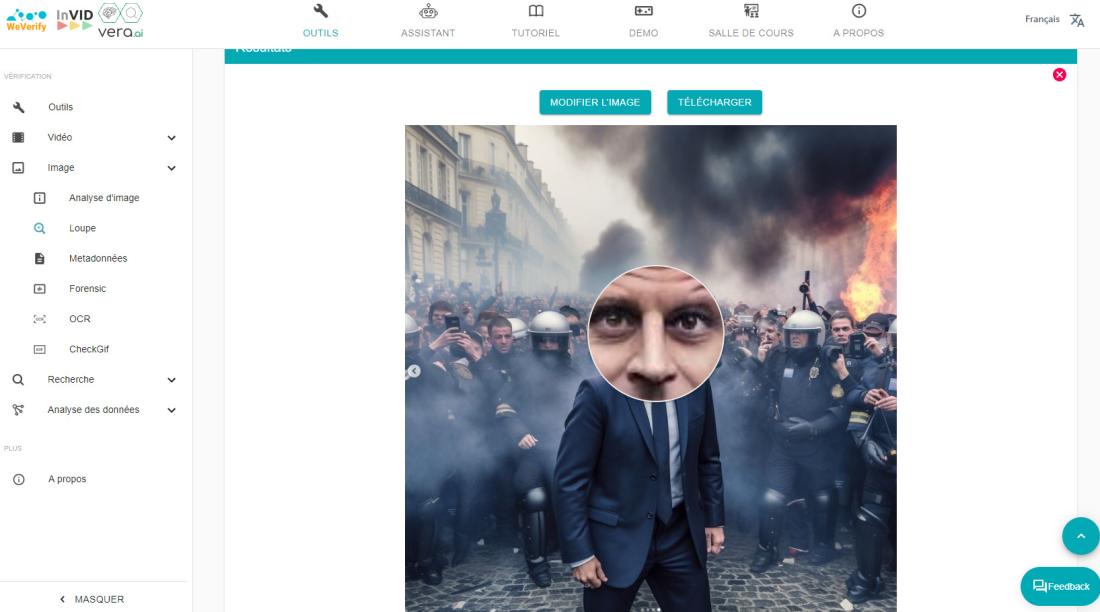

To je na primer slučaj na ovoj fotografiji francuskog predsednika Emanuela Makrona podeljenoj na Instagramu, a koju je generisao AI. Zumiranje pomoću alata za lupu preko besplatnog programa Invid/ViVerifaj pokazuje da su oči smeđe, a Makron ima plave oči. Takođe, nijansa braon boje se razlikuje između dva oka.

Generički alati često stvaraju i asimetrije. Lica mogu biti nesrazmerna ili uši imaju različite veličine.

Zube i kosu je teško imitirati i njihov izgled može otkriti, u svojim obrisima ili teksturi, da slika nije stvarna.

Neki elementi mogu biti loše integrisani, kao što su naočare za sunce koje se stapaju sa licem.

Stručnjaci takođe kažu da mešanje nekoliko slika može stvoriti probleme sa osvetljenjem na slici generisanoj veštačkom inteligencijom.

Proverite pozadinu

Dobar način da pronađete anomalije je da pažljivo pogledate pozadinu fotografije. Iako na prvi pogled može izgledati normalno, fotografije generisane veštačkom inteligencijom često pokazuju greške. Na primer na ovim fotografijama koje navodno prikazuju Baraka Obamu i Angelu Merkel na plaži, čini se da jedan od ljudi u pozadini ima odsečene noge.

"Što je element udaljeniji, objekat će biti više zamagljen, izobličen i imati pogrešnu perspektivu", rekao je Terasi.

Na lažnoj fotografiji sastanka Si Đinpinga i Putina, linija na stubu nije ravna. Glava ruskog lidera takođe deluje neproporcionalno u poređenju sa ostatkom njegovog tela. Fišindžer je za AFP rekao da su nedoslednosti ukazale da je slika generisana veštačkom inteligencijom.

Koristite zdrav razum

Neki elementi možda nisu izobličeni, ali i dalje mogu da odaju logičke greške. Kada sumnjate u sliku "dobro je osloniti se na zdrav razum", rekao je Fišindžer.

Na fotografiji ispod, koju je napravio AFP uz pomoć programa DALL-E i koja je trebalo da pokaže Pariz, nalazi se plavi znak za zabranjen ulazak kolima u ulicu, koji u Francuskoj ne postoji (crveni su).

Takav detalj, u kombinaciji sa isečenim vrhovima prstiju centralne ličnosti, kroasanom koji izgleda plastično i razlikom u osvetljenju na nekim prozorima, sugeriše da je fotografija generisana veštačkom inteligencijom.

Vodeni žig u donjem desnom uglu slike signalizira da je sliku generisao DALL-E.

Konačno, ako se tvrdi da slika prikazuje neki događaj, ali je njen kredibilitet sumnjiv, obratite se pouzdanim izvorima da biste potražili moguće nedoslednosti.

Članak je ažuriran dodavanjem meta podataka

26. april 2024. Članak je ažuriran dodavanjem meta podataka

Copyright © AFP 2017-2026. Za svaku vrstu komercijalne upotrebe ovog sadržaja potrebna je pretplata. Kliknite ovde za više informacija.

Videli ste sumnjivu informaciju na društvenim mrežama?

Kontaktirajte nas